某招聘网站招聘大数据分析案例2023新版(Python爬虫 + Hadoop + Spark + Hive + ECharts)

项目描述

综合运行大数据分析和可视技术,对使用爬虫程序从互联网上采集到的某招聘网站招聘岗位数据进行多维度分析,并可视化展示分析结果。

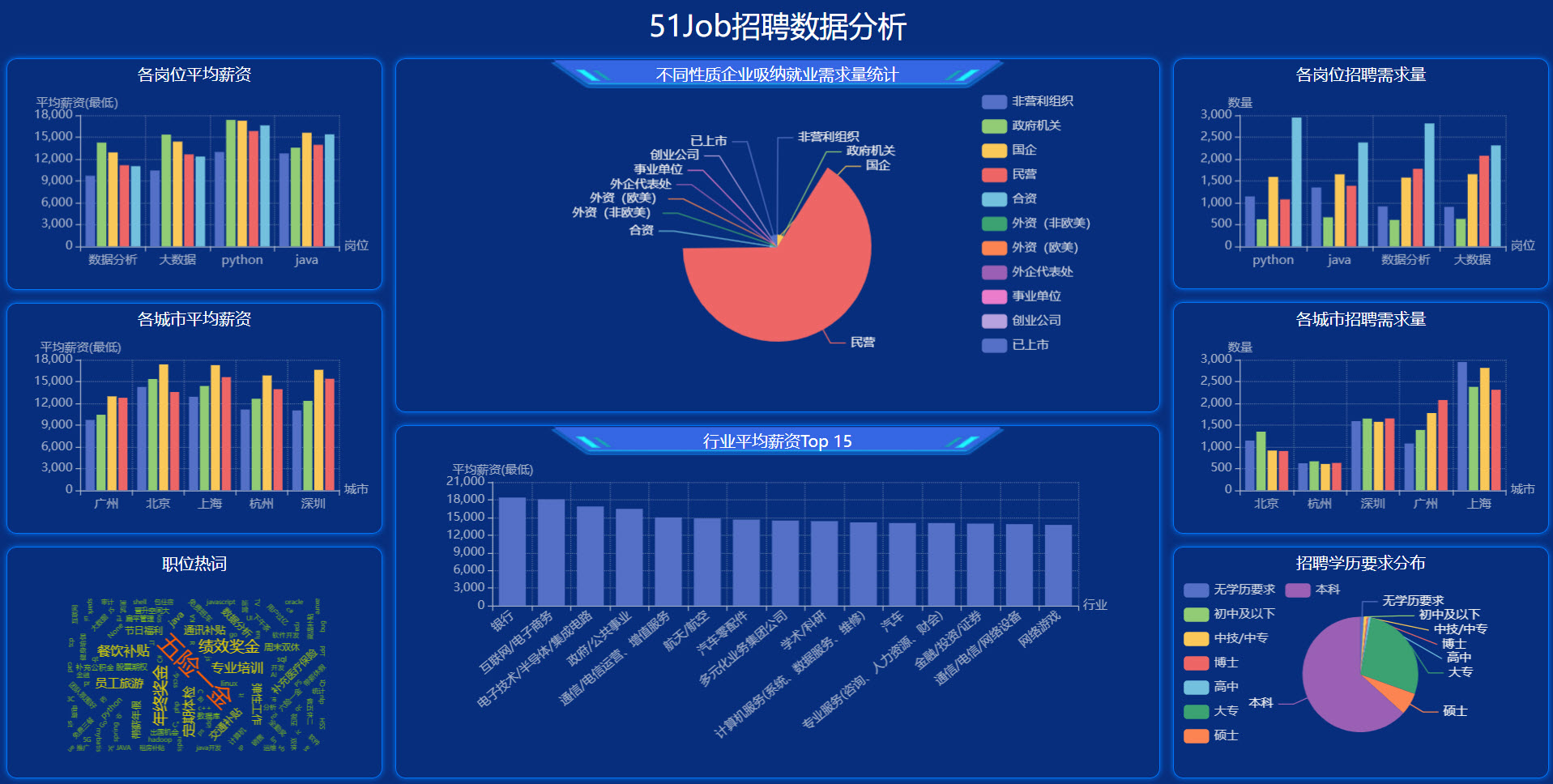

项目最终可视化展示结果如下图所示:

注:此项目是原招聘大数据分析(Spark实现)项目的升级。相较于老版本,主要涉及如下变动:

- 1. 51job网站服务器端代码重构了,对爬虫程序做了反爬措施,原爬虫程序无法继续使用。因此本项目重写了Python爬虫程序。

- 2. 最后的可视化展示,使用开源可视化框架代替了原版本中的Spring Web程序,展示结果更加漂亮且容易实现,使得项目能满足更多专业同学的大数据项目需求。

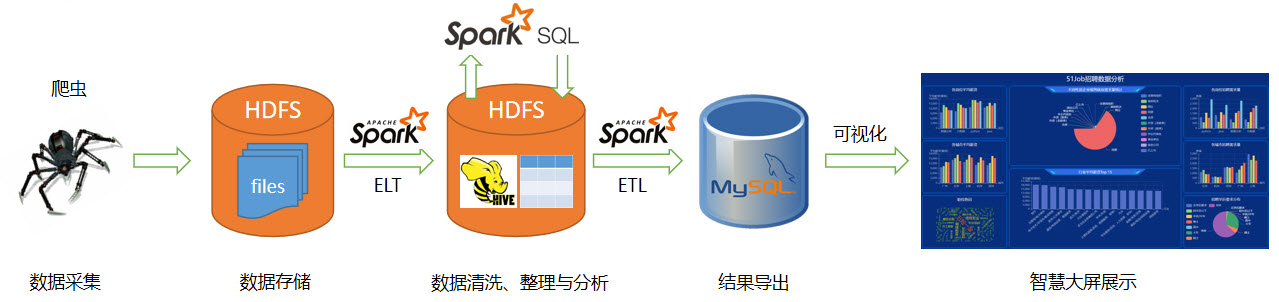

项目架构

项目流程

项目流程说明如下:

- 1. 数据采集:使用Python爬虫程序采集招聘网站公开的招聘信息数据;

- 2. 数据ELT:使用Spark实现数据的ELT过程;使用Hive数仓存储中间数据;

- 3. 数据清洗:使用Spark SQL + UDF进行数据清洗和整理;

- 4. 数据分析:使用Spark SQL进行数据多维度分析;

- 5. 结果导出:使用Spark实现数据从HDFS导出到MySQL数据库的ETL过程;

- 6. 数据可视化:使用开源可视化框架将分析结果展示在Web大屏上。

适用对象

本项目适合以下人员学习使用:

- 已有Spark基础,需要掌握大数据完整开发和分析流程、积累大数据项目经验;

- 大数据毕业设计项目。

如何获取源码?

本项目源码对小白学苑会员开放。会员可联系和咨询辅导老师。

项目实施过程

1. 数据采集本项目Python + selenium实现爬虫程序,实现从某招聘网站采集北京、上海、广州、深圳、杭州五个一线城市的Java、Python、大数据、数据分析这四个岗位的招聘信息。当然,会员可以任意扩展要采集的城市和岗位

2. 数据ETL项目使用Spark实现ETL过程,将采集到的数据从文件系统(本地或HDFS)抽取并加载到Hive数据仓库的ODS层。

3. 数据清洗使用Spark对Hive ODS层数据进行清洗,包括去重、错误数据处理、空值处理、属性转换、属性提取、维度数据抽取等数据预处理任务,并将处理后的数据写入Hive DWD层。

4. 数据探索与分析使用Spark SQL对数据集进行探索,并从多个维度对整理后的数据集进行分析,将分析结果写入Hive的DWS层。

5. 分析结果导出使用Spark实现ETL过程,将分析结果从Hive导出到MySQL数据库中。

6. 分析结果可视化使用开源大数据可视化框架(使用ECharts作为可视化组件),将分析结果展示在Web大屏上,可视化结果美观大方。

项目视频讲解

请点击下方链接,选择要播放的讲解视频。(注:正式用户登录方可观看全部项目视频)

本项目尚未提供讲解视频,请通过下载的文档和代码学习!