2022(7.20更新)高职大数据竞赛(任务书7)-数据采集与实时计算任务1:实时数据采集

子任务1

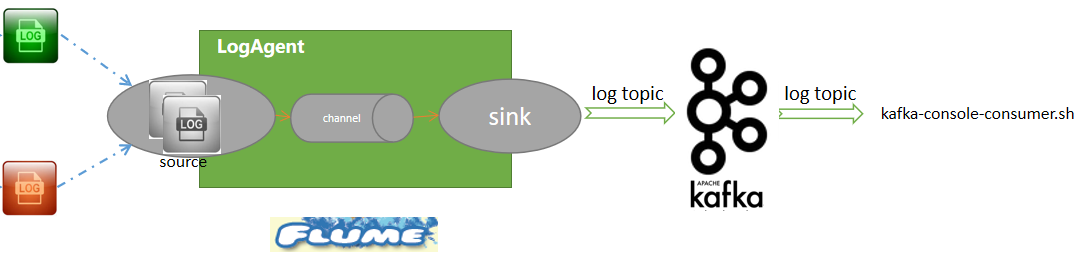

1、在Master节点使用Flume采集/data_log目录下实时日志文件中的数据,将数据存入到Kafka的Topic中(Topic名称分别为ChangeRecord、ProduceRecord和EnvironmentData,分区数为4),将Flume采集ChangeRecord主题的配置截图粘贴至对应报告中;

分析:这里考察的是Flume实时采集日志的配置和过程。因为后续实时分析只涉及到了ChangeRecord和ProduceRecord,所以这里只展示这两个数据的Flume配置,关于EnvironmentData的采集类似,大家自行实现。

实现原理

技术参考1:安装Apache Flume。

技术参考2:Flume集成Kafka。

测试环境:本案例演示使用小白学苑开发的PBCP(个人大数据竞赛平台)。

Flume配置

在$FLUME_HOME/conf/目录下,创建一个flume配置文件gs20 ......

......

抱歉,只有登录会员才可浏览!会员登录